Heeft u wel eens gehoord van het robots.txt bestand? De kans is aanwezig dat u hier nog geen kennis over hebt. In deze blog gaan wij daarom in op wat een robots.txt is en wat het nut is van dit bestand als onderdeel van uw website.

Wat is een robots.txt bestand?

Voordat wij dieper ingaan op het nut van een robots.txt bestand, is het eerst belangrijk om uit te leggen wat een robots.txt bestand is. Een robots.txt bestand is een tekstbestand dat in de root (hoofdmap) van een website geplaatst kan worden. Hiermee kan worden aangegeven welke delen van uw website niet door crawlers van zoekmachines gecrawld kunnen worden. Als dit bestand niet aanwezig is, dan gaat de crawler er vanuit dat de gehele website gecrawld mag worden. Voor SEO is dit niet altijd ideaal. Hier komen we later in deze blog op terug. Eerst willen we de werking van het robots.txt uitleggen aan de hand van een aantal voorbeelden.

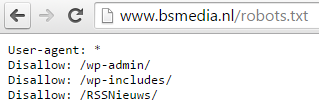

Het robots.txt bestand van B&S Media ziet er als volgt uit:

De bovenstaande regels zullen wij nu toelichten.

Met User-agent: * geven wij aan dat de daarop volgende regels voor alle robots gelden. Vervolgens krijgen de mappen /wp-admin/, /wp-includes/ en /RSSNieuws/ een ‘Disallow’. Dit houdt in dat alle robots geen toegang hebben tot deze en onderliggende mappen.

Het is ook mogelijk om de toegang te ontzeggen voor de gehele website aan een specifieke bot. Dit kan door de onderstaande regels toe te voegen aan uw robots.txt bestand:

User-agent: spammer

Disallow: /

Hiermee geeft u dus aan dat u aan ‘spammer’ de toegang tot alle mappen die onder / vallen ontzegt. Ook is het mogelijk om de toegang te ontzeggen voor een specifieke pagina. Voorbeeld:

User-agent: *

Disallow: /test-pagina

Waarom is het robots.txt bestand belangrijk?

Eerder in deze blog hebben wij al aangegeven dat een robots.txt bestand belangrijk kan zijn voor een optimale SEO inrichting van uw website. Maar waarom is dit bestand eigenlijk belangrijk?

Een robots.txt bestand is belangrijk voor SEO om verschillende redenen. Vaak zijn er altijd wel een aantal pagina’s die u om uiteenlopende redenen niet wilt weergeven in de zoekresultaten. Het kan zijn dat u een groot aantal pagina’s op uw website hebt staan die niet van belang zijn voor de zoekresultaten. Door deze pagina’s uit te sluiten, zal de zoekmachine sneller alleen de belangrijke pagina’s oppakken. Ook kunt u met het robots.txt duplicate content uitsluiten, hoewel u er beter voor kunt kiezen om een canonical tag te gebruik. Verder kunt u in het robots.txt bestand aangeven waar de sitemap van uw website zich bevindt. Ook niet onbelangrijk voor SEO!

Belangrijk om te weten

Het is belangrijk dat een robots.txt met grote zorgvuldigheid wordt aangemaakt. Anders loopt u de kans dat u toegang tot alle pagina’s van uw website ontzegt, waardoor een crawler als Google uw website niet meer bekijkt. Daardoor zult u volledig zult verdwijnen uit de organische zoekresultaten van Google. Dit wilt u uiteraard te allen tijde voorkomen.. Wij raden daarom aan om uw robots.txt bestand altijd goed na te kijken en te testen. Dit kan onder andere in Google Webmaster Tools.

Mocht u hulp nodig bij het aanmaken of wijzigen van uw robots.txt bestand, dan helpen wij u graag!