Ga je aan de slag met verbeteringen op het gebied van SEO? Dan denk je al gauw aan het optimaliseren van de content en het verhogen van de autoriteit van je website. Echter kunnen technische optimalisaties in dit proces niet ontbreken. Want hoe kunnen goede SEO pagina’s werken als je website bijvoorbeeld niet wordt geïndexeerd? Met deze checklist kun je eenvoudig vaststellen of de techniek van je website in orde is, of dat er essentiële optimalisaties doorgevoerd moeten worden!

Wat is technische SEO en waarom is het belangrijk?

De techniek van je website op orde hebben is een vereiste voor een goede organische vindbaarheid. Google geeft namelijk de voorkeur aan websites die technisch goed presteren. Echter zorgt het er niet alleen voor dat Google je website meer waardeert, ook de gebruiker heeft er baat bij. Een technisch geoptimaliseerde website draagt bij aan de gebruiksvriendelijkheid en algehele prestatie van je website!

Indexeerbaar

De meeste websites zijn indexeerbaar. Toch komt het soms voor dat een website niet indexeerbaar is. Als dit het geval is, zullen al je inspanningen geen resultaat hebben. Het is dus belangrijk om te controleren of je website wel indexeerbaar is. Dit kun je o.a. doen door in de broncode te zoeken op ‘noindex’. Als er ‘noindex’ is opgenomen, wil dit vaak zeggen dat de website uitgesloten is voor indexatie.

Robots.txt bestand

Met een robots.txt bestand kun je instructies geven aan de ‘robots’ die je website crawlen. Hiermee kun je aan de zoekmachines duidelijk maken welke pagina’s ze niet mogen crawlen, zodat ze niet in de zoekmachines terecht komen. Daarnaast vertelt het robots.txt bestand hoe de robots je website efficiënt kunnen crawlen.

Vanuit SEO oogpunt is het belangrijk dat het robots.txt bestand correct geformatteerd is, zodat het alleen de pagina’s blokkeert die je niet wilt laten indexeren. Daarnaast moet ook de XML sitemap in het bestand worden opgenomen. Google heeft namelijk maar beperkt de tijd om je website te crawlen. Met een sitemap kan een robot direct de “wegenkaart” van jouw website vinden en daarmee je site efficiënt crawlen.

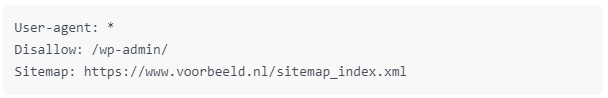

Hieronder een simpel voorbeeld van hoe het robots.txt bestand van een WordPress website eruit kan zien:

*: Met het sterretje geef je aan dat de instructies zijn bedoeld voor alle zoekmachines.

Disallow: Deze instructie geeft aan welke content niet toegankelijk is voor de user-agent (zoekmachines).

Hoe te controleren:

Google Search Console > Crawlen > robots.txt-tester

Statuscodes

Status codes worden gebruikt om de communicatie tussen de browser en de server goed te laten verlopen. Dus elke keer wanneer een pagina van jouw website wordt opgevraagd, geeft de server een reactie door middel van een status code. Deze informatie over de status van het verzoek kan nuttig zijn. Wanneer er bijvoorbeeld iets mis gaat met het ophalen van een pagina, kan dit allerlei oorzaken hebben. Dankzij de status code kun je het probleem bij de kern oplossen. Hieronder een overzicht van de meest voorkomende status codes:

301 – Permanent redirect

302 – Found (vaak als temporary redirect gebruikt)

400 – Bad request

401 – Unauthorized

403 – Forbidden

404 – Not found

500 – Internal server error

503 – Service unavailable

Krijg je op pagina’s vreemde statuscodes te zien? Dan is het belangrijk dat deze onderzocht en opgelost worden.

Hoe te controleren:

Google Search Console > Crawlen > Fetchen als Google

Technische duplicate content

Google gaat ervan uit dat elke unieke url van je website een op zichzelf staande pagina met unieke content is. Wanneer je pagina dus via verschillende urls te benaderen is ziet Google dit als unieke pagina’s, terwijl ze exact dezelfde content bevatten. Bijvoorbeeld zowel via www.voorbeeld.nl als via voorbeeld.nl en ook nog via www.voorbeeld.nl/home. Het is daarom essentieel dat alle pagina’s van je website via één url te benaderen zijn. Hiervoor dien je alle url-variaties te redirecten (301 redirect) naar de url zoals je deze wilt voeren. Zorg daarom voor de volgende redirects om (technische) duplicate content te voorkomen:

- http:// redirect naar https:// versie

- trailing slash redirect naar non-trailing slash variant of vice versa

- non-www versie redirect naar www. versie of vice versa

- pagina’s die zowel met als zonder hoofdletter te benaderen zijn: pagina’s met hoofdletter redirecten naar pagina’s zonder hoofdletter

De laadtijd van je website

De snelheid van je website is een belangrijk onderdeel van de vindbaarheid in Google. Google toont liever geen trage websites in de zoekresultaten. Want als Google verwijst naar een website die er lang over doet om te laden, leidt dat niet tot een tevreden gebruiker. Daarom is het van belang ook de laadtijd van je website te checken. Dit kun je doen met de PageSpeed Insights tool van Google. Heb je een trage website? De onderstaande drie best practices zorgen doorgaans al voor grote winst in de pagina laadtijd:

- Code voor browsercaching toevoegen aan het .htaccess bestand van de website.

- Code voor GZIP-compressie toevoegen aan het .htaccess bestand van de website.

- Afbeeldingen verkleinen (qua bestandsgrootte). Lees hier meer over het gebruik van Kraken.

Mobielvriendelijke website

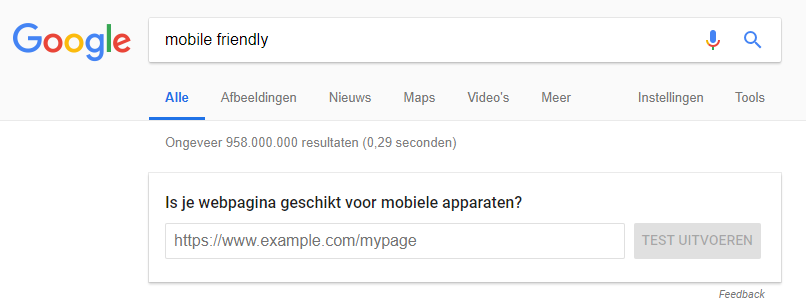

Veel mensen maken gebruik van een smartphone of tablet bij het bezoeken van een website. Daarom is het erg belangrijk dat je website hiervoor ook geschikt is. Via Google kun je nagaan of dit het geval is:

Wanneer dit niet het geval is, is het belangrijk je website geschikt te (laten) maken voor mobiel gebruik.

Hulp nodig bij technische SEO optimalisaties?

Deze checklist bevat een overzicht van de belangrijkste technische punten op het gebied van SEO. Staat de techniek van jouw website nog niet goed op deze punten? Dan is het essentieel deze op orde te (laten) maken. Vind je dit ingewikkeld of teveel werk? Laat de SEO specialisten van B&S Media je dan helpen!